PLUS

生成AIコラム

うさぎでもわかる!GPT-oss、OpenAIが遂に本気でオープンソースに参戦!

目次:

はじめに

2025年8月5日、AI業界に衝撃が走りました。OpenAIが約5年ぶりに*オープンウェイトモデル「gpt-oss」をリリースしたのです!GPT-2以来となるこの大胆な戦略転換は、生成AI業界に何をもたらすのでしょうか。

*オープンウェイトモデルとは、誰もが自由に利用できる学習済みのAIモデルのことです。

オープンソースコミュニティにとって待ちに待った瞬間がついに訪れました。しかも、Apache 2.0ライセンスという最も自由度の高いライセンスでの提供です。これはもう、うさぎも飛び跳ねて喜ぶレベルの大ニュースですよ~🐰

本記事では、gpt-ossの技術的特徴から実際の性能、そして今後の生成AI業界への影響まで、徹底的に解説していきます。

gpt-ossとは何か

モデルラインナップ

gpt-ossは2つのサイズで提供されています。

| モデル | レイヤー | パラメータ合計 | トークンあたりのアクティブパラメータ数 | エキスパート合計 | トークンあたりのアクティブエキスパート数 | コンテキスト長 |

|---|---|---|---|---|---|---|

| gpt-oss-120b | 36 | 117b | 5.1b | 128 | 4 | 128k |

| gpt-oss-20b | 24 | 21b | 3.6b | 32 | 4 | 128k |

gpt-oss-120b

- 総パラメータ数は1200億

- アクティブパラメータは51億(MoEアーキテクチャのため)

- 80GB GPUで動作可能

- データセンターやワークステーションでの利用を想定

gpt-oss-20b

- 総パラメータ数は200億

- アクティブパラメータは36億

- 16GBメモリで動作可能

- MacBookなどのコンシューマーハードウェアでも実行可能

技術的特徴

MoE(Mixture of Experts)アーキテクチャ

MoEは、複数の専門家モデルを組み合わせる革新的なアーキテクチャです。各入力に対して、最適な専門家モデルが選択されて処理を行うため、巨大なパラメータ数を持ちながらも、実際の計算コストは大幅に削減されます。

うさぎの経験では、MoEモデルは特定のタスクにおいて驚くほど効率的なんです。まるで専門家チームが協力して問題を解決しているような感じですね!

4ビット量子化(mxfp4)対応

最新の量子化技術により、モデルサイズを大幅に削減しながら、精度の低下を最小限に抑えています。これにより、より多くのハードウェアで実行可能になりました。

Apache 2.0ライセンスがもたらす可能性

完全な商用利用の自由

Apache 2.0ライセンスは、最も自由度の高いオープンソースライセンスの一つです。これにより、以下のことが可能になります。

- 制限なしの商用展開 ユーザー数や収益に関する制限なし

- 自由なファインチューニング 独自データでのカスタマイズが完全に自由

- 派生モデルの作成と配布 改良版を作成し、独自のライセンスで配布可能

- 特許リスクからの保護 Apache 2.0には特許保護条項が含まれる

プライバシーとセキュリティの向上

オンプレミス展開が可能になることで、以下のメリットが得られます。

- データの完全なコントロール 外部APIにデータを送信する必要なし

- 規制対応の容易さ GDPR、HIPAAなどの規制に対応しやすい

- レイテンシの削減 ローカル実行により応答速度が向上

うさぎの経験では、企業のお客様はデータのプライバシーを非常に重視されます。gpt-ossはその懸念を完全に解消できる素晴らしいソリューションですね!

クローズドモデルとの性能比較

主要ベンチマーク結果

調査の結果、gpt-ossの性能は非常に印象的でした。以下、主要なベンチマークでの結果をまとめます。

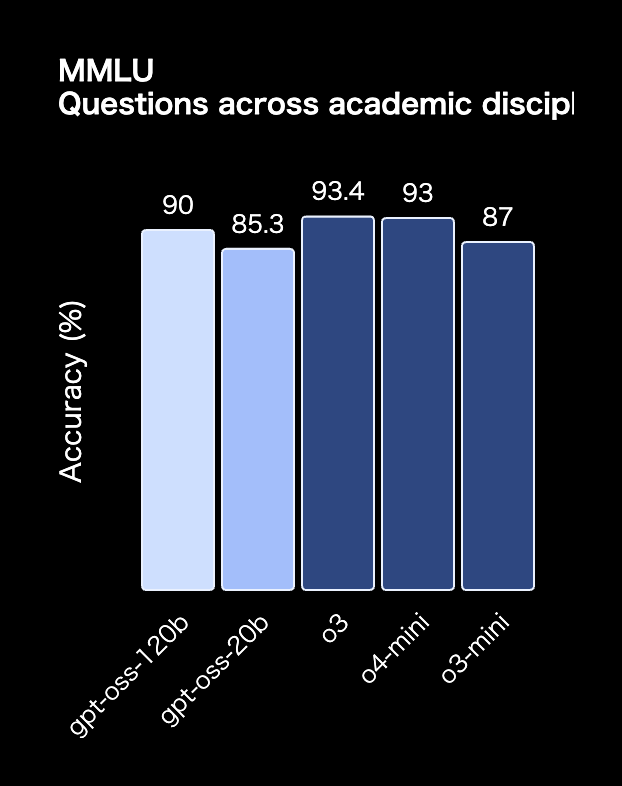

MMLU(一般知識評価)

MMLUは大学レベルの知識を問うベンチマークで、gpt-oss-120bは主流モデルのo3、o4-miniに近い結果を示しています。

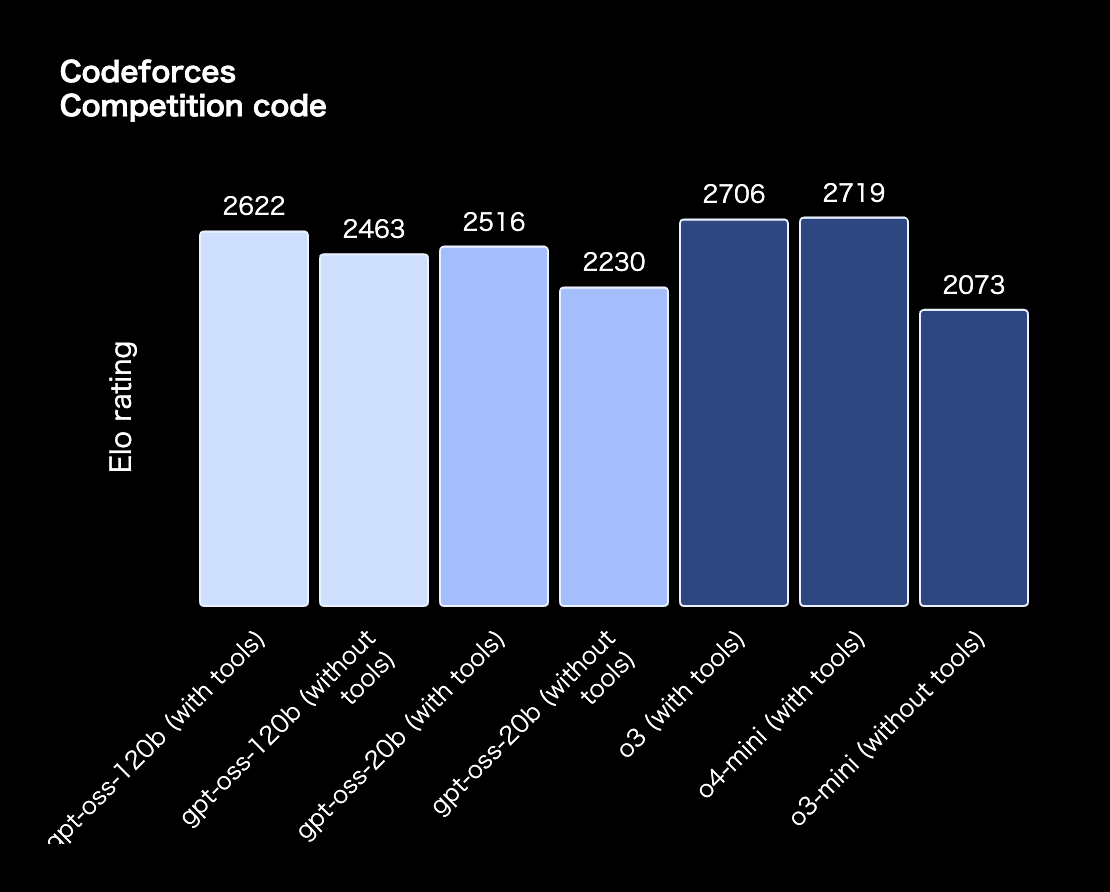

Codeforces(競技プログラミング)

競技プログラミングの能力でも、gpt-oss-120bがo3-miniを大きく上回り、o3やo4-miniに迫る性能を示しています。

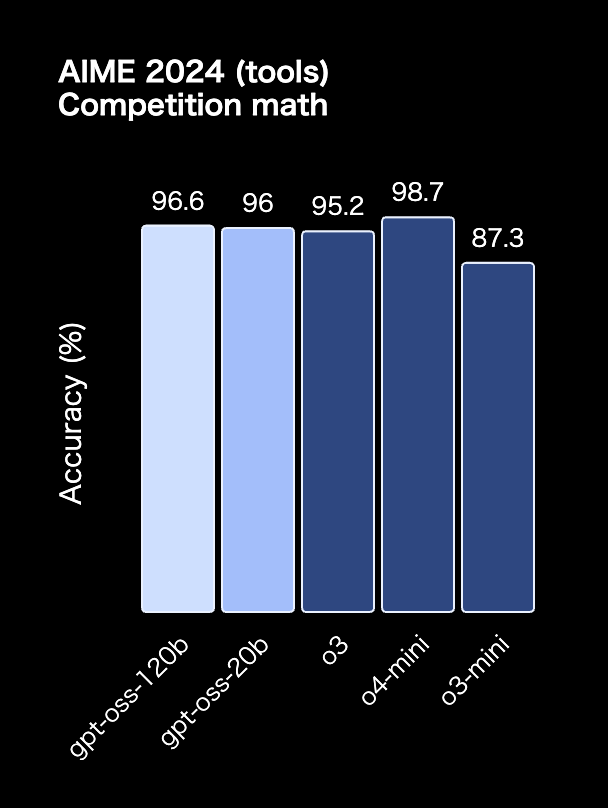

AIME 2024(数学競技)

数学の問題解決能力では、gpt-oss-120bがo3を上回る驚異的な結果を達成しました。

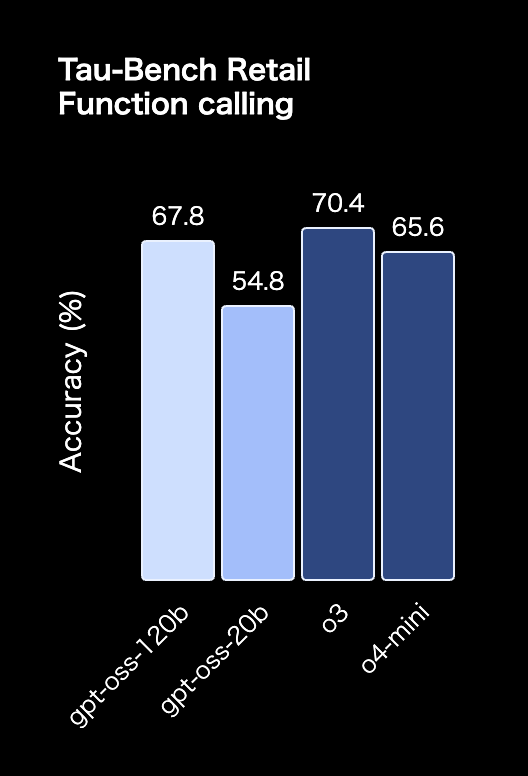

TauBench(ツール使用能力)

実世界のタスクを模したツール使用能力でも、優れた性能を発揮しています。

OpenAI自社モデルとの位置づけ

gpt-ossの位置づけを整理すると、以下のようになります。

- gpt-oss-120b: o3-miniを明確に上回り、多くのタスクでo4-miniと同等以上

- gpt-oss-20b: o3-miniと同等以上、特に数学タスクでは上回る性能

これは、オープンソースモデルとしては画期的な性能です。特に、商用利用可能なApache 2.0ライセンスでこのレベルの性能が提供されることは、業界にとって大きな意味を持ちます。

実装と利用方法

利用可能なプラットフォーム

gpt-ossは既に多くのプラットフォームで利用可能です。

Hugging Face Transformersでの実行

最も簡単な実装方法を紹介します。

from transformers import pipeline

import torch

# モデルの読み込み

model_id = "openai/gpt-oss-120b"

pipe = pipeline(

"text-generation",

model=model_id,

torch_dtype="auto",

device_map="auto",

)

# 推論の実行

messages = [

{"role": "user", "content": "量子コンピュータの原理を簡潔に説明してください。"},

]

outputs = pipe(

messages,

max_new_tokens=256,

)

print(outputs["generated_text"][-1])Ollamaでのローカル実行

より手軽にローカルで実行したい場合は、Ollamaがおすすめです。

# Ollamaのインストール後

ollama run gpt-oss:20b

# または120Bモデル(要高性能GPU)

ollama run gpt-oss:120bvLLMでの高速推論

大規模な推論を行う場合は、vLLMが最適です。

# vLLMのインストール

uv pip install --pre vllm==0.10.1+gptoss

# サーバーの起動

vllm serve openai/gpt-oss-120bファインチューニングによるカスタマイズ

TRLライブラリで簡単に業界特化型モデルを作成

AIがデータを読みやすくなるように適切な学習を行う*ファインチューニングは、gpt-ossの真価を発揮する重要な機能です。特にTRL(Transformers Reinforcement Learning)ライブラリを使用することで、驚くほど簡単に業界特化型モデルを作成できます。

*ファインチューニングとは、事前に学習済みのAIモデルを特定の用途に合わせて追加学習させることです。

TRLライブラリの特徴

TRLライブラリは、Hugging Faceが開発したファインチューニング専用ライブラリで、以下の利点があります。

- 効率的な学習 LoRA(Low-Rank Adaptation)を使用したメモリ効率の良い学習

- 多様な学習手法 SFT(Supervised Fine-Tuning)からGRPOまで幅広い手法に対応

- 簡単な実装 わずか数行のコードでファインチューニングが可能

- 企業レベルの実用性 大規模モデルでも効率的に学習可能

うさぎのおすすめはGRPO学習!

うさぎの経験では、GRPO(Group Relative Preference Optimization)での学習が特におすすめです🐰

GRPOは従来の強化学習の手法であるRLHF(Reinforcement Learning from Human Feedback)よりも安定性が高く、特に業界特化型の応答品質向上に優れた効果を発揮します。

業界特化型モデルの具体例

実際に作成可能な業界特化型モデルの例をご紹介します。

医療分野

- 医療用語に特化した質問応答システム

- 診断支援や薬剤情報の提供

- 医学論文の要約と解析

法務分野

- 契約書の分析と要点抽出

- 法的文書の自動生成

- 判例検索と類似案件の特定

金融分野

- 市場分析レポートの自動生成

- リスク評価モデルの構築

- 投資戦略の提案システム

製造業

- 品質管理データの分析

- 予防保全計画の最適化

- 製造プロセスの改善提案

うさぎの経験では、まずは1000件程度の高品質なデータセットでも、驚くほど効果的な業界特化型モデルが作成できます。特に、gpt-ossは既に高度な推論能力を持っているため、少量のデータでも大きな効果が期待できるのです!

実際の活用シーン

エンタープライズ向け活用

社内AIアシスタントの構築

- 機密情報を外部に送信せずにAIアシスタントを構築

- 社内ナレッジベースと統合した高度な質問応答システム

- カスタマイズ可能な業界特化型モデルの開発

コンプライアンス対応

- 金融、医療、政府機関での利用に適合

- 監査可能な推論プロセス

- データローカリゼーション要件への対応

研究開発向け活用

新しいアーキテクチャの検証

- MoEアーキテクチャの改良研究

- 効率的な推論手法の開発

- マルチモーダル拡張の実験

ファインチューニング研究

- ドメイン特化型モデルの開発

- 少量データでの効果的な学習手法の研究

- 継続学習メカニズムの実装

個人開発者向け活用

プライバシー重視アプリケーション

- 完全オフラインで動作するAIアシスタント

- エッジデバイスでの推論

- ユーザーデータを一切収集しないサービス

創造的なプロジェクト

- カスタムチャットボットの開発

- ゲームAIの実装

- 教育用AIツールの作成

今後の展望と業界への影響

OpenAIの戦略転換の意味

OpenAIがオープンソースに回帰した背景には、いくつかの要因が考えられます。

- 競争環境の変化 Meta、Mistral、DeepSeekなどの強力なオープンモデルへの対抗

- エコシステムの構築 開発者コミュニティの支持獲得

- 市場の多様化 APIビジネスとは異なる収益源の確保

オープンソースコミュニティへの影響

gpt-ossのリリースは、オープンソースAIコミュニティに大きな波及効果をもたらすでしょう。

- ベンチマークの引き上げ 他のオープンモデル開発者への刺激

- 技術の民主化 高性能AIへのアクセスがより広く開放

- イノベーションの加速 新しいアプリケーションやユースケースの創出

生成AI業界の今後

うさぎの予想では、今後以下のようなトレンドが加速すると考えています。

- ハイブリッドモデルの普及 クラウドとエッジの使い分け

- カスタマイズの重要性向上 業界特化型モデルの需要増加

- プライバシー重視の流れ ローカル実行可能なモデルへの需要

まとめ

OpenAIのgpt-ossリリースは、生成AI業界にとって歴史的な転換点となるでしょう。Apache 2.0ライセンスでの提供により、真の意味でのオープンイノベーションが可能になりました。

主なポイントをまとめると、以下の通りです。

- 性能面 o3-miniを上回り、o4-miniに匹敵する驚異的な性能

- 実用性 コンシューマーハードウェアでも動作可能な20Bモデル

- 自由度 Apache 2.0による完全な商用利用の自由

- 将来性 オープンソースコミュニティとの協業による更なる発展

これは単なる新モデルのリリースではありません。AIの民主化に向けた大きな一歩であり、私たち開発者にとって素晴らしい機会の到来です。

さあ、あなたもgpt-ossを使って、新しいAIアプリケーションを作ってみませんか?うさぎも応援していますよ~!🐰

参考リンク

- OpenAI gpt-oss公式ブログ

- Hugging Face gpt-ossモデルページ

- GitHub gpt-ossリポジトリ

- Ollama gpt-ossページ

- OpenAI Cookbook: TRLでのファインチューニングガイド

あなたも生成AIの活用、始めてみませんか?

生成AIを使った業務効率化を今すぐ始めるなら

「初月基本料0円」「ユーザ数無制限」のナレフルチャット!

生成AIの利用方法を学べる「公式動画」や、「プロンプトの自動生成機能」を使えば

知識ゼロの状態からでも、スムーズに生成AIの活用を始められます。

taku_sid

https://x.com/taku_sid

AIエージェントマネジメント事務所「r488it」を創立し、うさぎエージェントをはじめとする新世代のタレントマネジメント事業を展開。AI技術とクリエイティブ表現の新たな可能性を探求しながら、次世代のエンターテインメント産業の構築に取り組んでいます。

ブログでは一つのテーマから多角的な視点を展開し、読者に新しい発見と気づきを提供するアプローチで、テックブログやコンテンツ制作に取り組んでいます。「知りたい」という人間の本能的な衝動を大切にし、技術の進歩を身近で親しみやすいものとして伝えることをミッションとしています。