PLUS

生成AIコラム

ChatGPTの情報漏洩リスクとは?3つの事例と11の対策方法を紹介

目次:

はじめに

「ChatGPTを業務で導入したいが、情報漏洩が心配」「機密情報を入力しても大丈夫?」「実際にどんな事例があるの?」こうした不安を抱える企業担当者は多いでしょう。

ChatGPTは業務効率化に大きな効果をもたらすツールですが、入力データの学習利用やアカウント情報の流出など、企業にとって深刻なセキュリティリスクも存在します。そのため、適切な対策なしに利用することは危険です。

本記事では、ChatGPTで発生する3つの主要なリスクから実際の漏洩事例、そして企業が今すぐ実施できる11の対策方法まで詳しく解説します。正しい知識を身につけて、ChatGPTを安全かつ効果的に活用していきましょう。

生成AI導入をお考えの企業様へ

ナレフルチャットは企業の生成AI活用を安全かつ効率的に支援するツールです。セキュリティ対策から社内浸透まで、AI導入をトータルサポートいたします。企業でのAI導入を検討している方は、こちらをご覧ください。ChatGPTで発生する情報漏洩リスク

リスクを理解することで、適切な対策を講じることが可能になります。ChatGPTの利用において企業が注意すべき、代表的な情報漏洩リスクを3つ紹介します。

- 入力した情報の漏洩

- アカウント情報の漏洩

- チャット履歴の漏洩

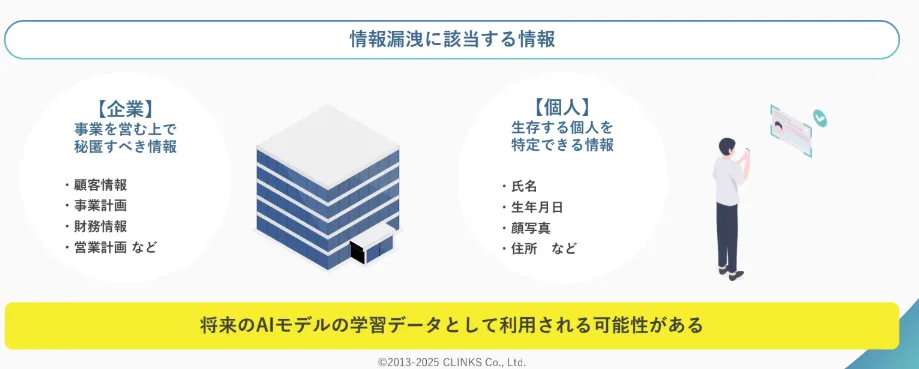

入力した情報の漏洩

ChatGPTにユーザーが入力した情報は、将来のAI学習データとしてChatGPT内に蓄積されてしまう可能性があります。そのため、企業の機密情報を入力するとその情報が永続的にシステム内に保持され、他のユーザーの回答生成に影響を与える危険性があるのです。

また、入力された情報はChatGPTを運営しているOpenAI社のサーバーに保存されるため、必然的に社外への情報流出が発生したことになります。このChatGPTの仕組みが、意図せずして重要な情報を第三者に公開してしまう危険性を生み出しており、企業にとって最も注意すべきリスクの一つといえるでしょう。

ChatGPTの仕組みについては以下の記事で詳しく解説していますので、ご参照ください。

参考記事:うさぎでもわかる ChatGPTの仕組み AIの中身をやさしく解説!

アカウント情報の漏洩

ChatGPTのアカウント情報が第三者に流出すると、不正ログインによる会話履歴の閲覧や機密情報の窃取が発生する可能性があります。アカウント情報の流出原因としては、パスワードの使い回し、弱いパスワードの設定、マルウェア感染による情報窃取などが挙げられます。

流出したアカウント情報は、ダークウェブの闇市場で売買される実態も確認されており、企業にとって深刻なセキュリティリスクとなります。

チャット履歴の漏洩

ChatGPTのシステム障害やバグにより、本来は非公開であるはずのチャット履歴が他のユーザーに表示されるリスクもあります。このようなシステムレベルの問題では、ユーザー側での対策が困難であり、OpenAI社などのサービス提供者の技術的対応に依存する部分が大きいです。

企業の業務でChatGPTを活用している場合、チャット履歴には顧客情報、プロジェクトの詳細、社内の意思決定プロセスなどの、機密性の高い情報が含まれている可能性が高く、意図しない情報漏洩により企業の優位性や信頼性に大きな影響を与える危険性があると言えるでしょう。

ChatGPTで実際に情報漏洩が発生した事例

ここでは、ChatGPTで実際に情報漏洩が発生した事例を3つ紹介します。

以下の事例から、企業がどのような点に注意すべきかを学ぶことができます。

- OpenAI社での個人情報漏洩事例

- サムスン社での機密情報漏洩事例

- マルウェアによるアカウント情報流出

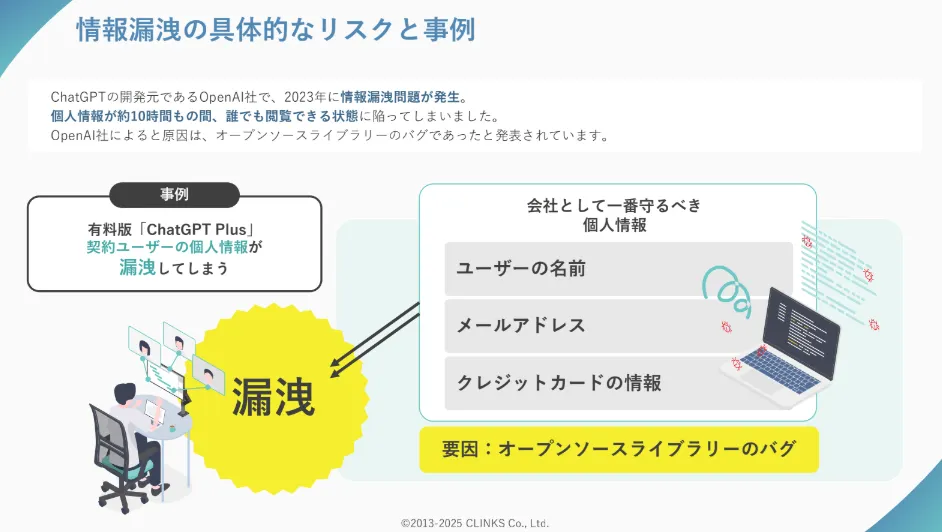

OpenAI社での個人情報漏洩事例

OpenAI社は2023年3月に、ChatGPTの有料プラン「ChatGPT Plus」利用者の個人情報が漏洩したと公式発表しました。この事例では、約10時間にわたり一部ユーザーの個人情報が他のユーザーから閲覧可能な状態となっていたのです。

漏洩した情報にはユーザーの名前、メールアドレス、クレジットカードの情報が含まれていたとされています。OpenAI社は原因はオープンソースライブラリーのバグであったと発表していますが、有料版でも情報漏洩のリスクが存在することを示す事例となりました。

参照:「3月20日のChatGPT障害:何が起こったのか」OpenAI

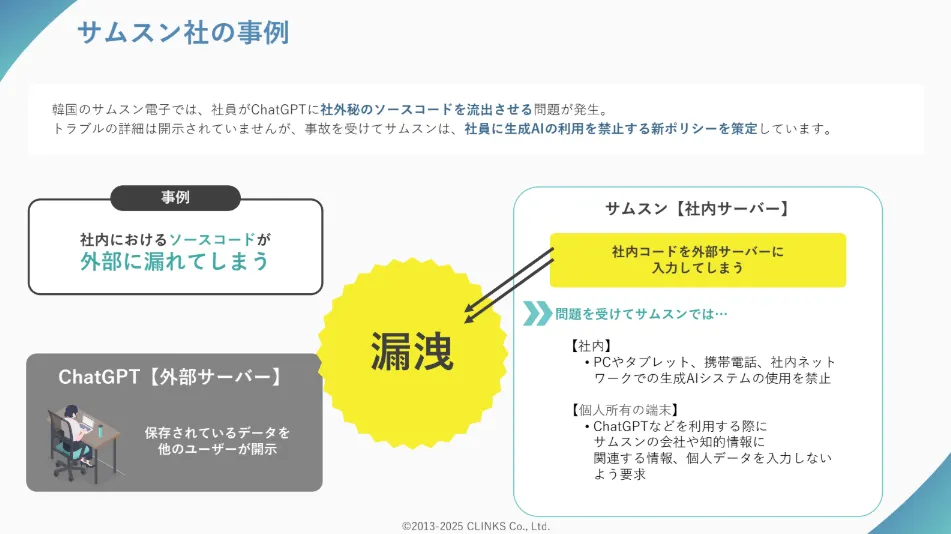

サムスン社での機密情報漏洩事例

韓国のサムスン電子では、社員がChatGPTに社内機密のソースコードを入力する問題が発生しました。

IT企業にとってソースコードは企業価値の源泉です。それが学習データに取り込まれ、将来的に他のユーザーへの回答として出力される可能性がある行為は、重大なセキュリティインシデントといえます。

これを受けてサムスン社では、PC、タブレット、携帯電話、社内ネットワークでの生成AIシステムの使用を禁止し、個人所有端末でのChatGPT利用時には機密情報の入力しないよう要求する新ポリシーを策定しています。

企業における、生成AI利用の難しさを浮き彫りにした事例といえるでしょう。

参照:「サムスン、ChatGPTの社内使用禁止 機密コードの流出受け」Forbes JAPAN

マルウェアによるアカウント情報流出

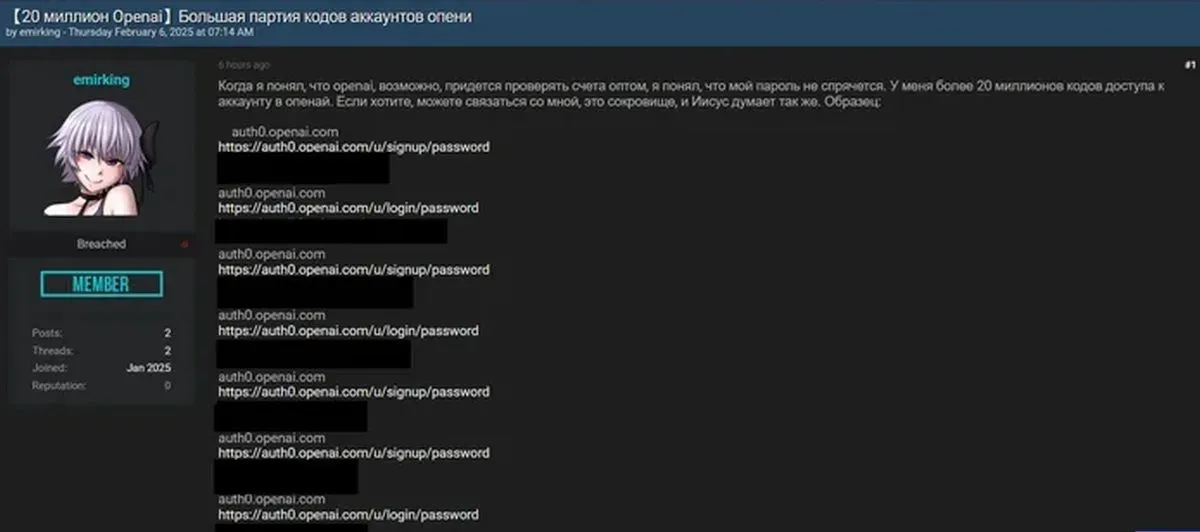

セキュリティ企業Malwarebytesの調査によると、2025年2月に「emirking」というハンドルネームのサイバー犯罪者が、ダークウェブのフォーラムで2000万件を超えるOpenAIアカウントの認証情報を販売していることが判明しました。

emirkingによる投稿

引用:「2000万のOpenAIアカウントが売りに出されている」Malwarebytes LABS

この規模の認証情報は通常のフィッシング攻撃では取得が難しいため、OpenAIの認証システムに何らかの脆弱性があり、それが悪用された可能性も指摘されています。

盗まれた認証情報が悪用されると、過去の会話履歴に含まれる機密情報へのアクセス、標的型フィッシング詐欺への利用、OpenAIの有料機能の不正利用などの被害が想定されます。

企業でChatGPTを利用している場合、業務上の重要な情報が第三者に窃取される深刻なリスクがあるのです。

ChatGPT上で実施されている情報漏洩対策

情報漏洩を防ぐには、まずChatGPTを運営しているOpenAI社がどんな対策をしているかを知ることが大切です。運営側の対策を理解して、自社に合ったプランを選べば、機密情報をより安全に扱えます。

ここでは2つの観点を紹介します。

- OpenAI社の取り組み

- ChatGPTのプランごとのセキュリティ対策

OpenAI社の取り組み

OpenAI社は、ユーザーの機密情報を守るため複数の防御策を実装しています。

その情報保護の中心となるのがデータ暗号化です。入力した情報はAES-256で暗号化され、通信中もTLS1.2以上で保護されます。また、社内では従業員のデータアクセスを厳しく制限し、内部からの情報流出も防いでいます。

信頼性の証明として、SOC 2 Type II認証などの第三者による監査も定期的に受けており、様々なセキュリティ認証をクリアしていることが確認されています。

取得しているセキュリティ認証

ただし、これらの対策があっても、使い方や設定次第では情報が漏れる可能性があるため、正しい利用方法を身につけることが重要です。

ChatGPTのプランごとのセキュリティ対策

ChatGPTの情報漏洩リスクは、選ぶプランで大きく変わります。個人向けと法人向けでは機密情報の保護レベルが違うため、企業利用では適切なプラン選択が欠かせません。

OpenAI 全体が様々な認証に準拠したセキュリティ基盤で運営されており、個人向けプランでもその恩恵を受けています。

ただし、Business や Enterprise プランでは、監査ログ・SSO といった組織向けの管理機能が追加されるため、企業利用に適した水準を確保できます。

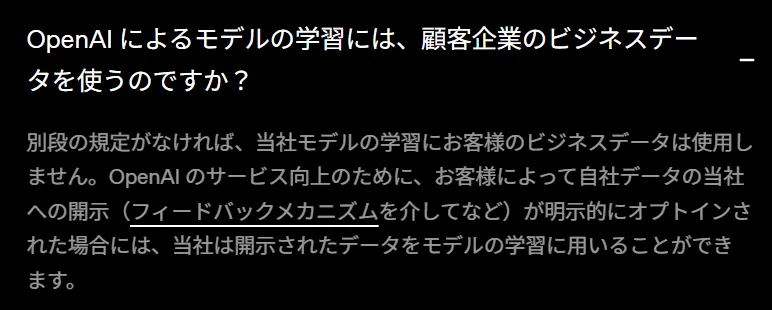

| プラン区分 | 情報漏洩リスク | 主な保護機能 |

|---|---|---|

| 個人向け (無料・Plus・Pro) | 設定でモデル訓練への利用を防止することが可能 | 基本的な暗号化 |

| 法人向け (Enterprise・Business) | デフォルトでビジネスデータはモデル訓練に使われない保証あり | 高度な暗号化、アクセス管理 |

機密情報を扱う企業は、漏洩リスクが低いEnterprise・Businessプランがおすすめです。利用状況の監視や詳細ログ機能もあり、万が一の際も早期発見できます。

ChatGPT Enterpriseについては、以下で詳しく解説しておりますので、ご参照ください。

参考記事:ChatGPT Enterpriseとは?他プランとの違い・導入時の注意点を解説

ChatGPT利用時の情報漏洩対策11選

ここからは、企業がChatGPTを安全に活用するために実施すべき11の対策方法を解説します。これらの対策を組み合わせることで、情報漏洩リスクを大幅に軽減できます。

- 機密情報や個人情報を入力しない

- ChatGPTに履歴が残らない設定にする

- APIを利用する

- 有料プランを利用する

- 定期的にパスワードを変更する

- 社内での利用ルールを設ける

- 入力情報の監視をする

- セキュリティシステムを導入する

- 利用者のAIリテラシーを向上させる

- アカウントの使い回しをしない

- 法人向け生成AIサービスを導入する

1.機密情報や個人情報を入力しない

最も基本的かつ重要な対策は、ChatGPTに機密情報や個人情報を一切入力しないことです。ChatGPTに入力された情報は、AIモデルの学習データとして利用される可能性があるため、企業にとって重要な情報は絶対に入力してはいけません。

これらの情報を相談したい場合は、匿名化や仮名化を行った上で利用することをおすすめします。具体的には「A社の売上データ」を「ある企業の売上データ」に置き換えるなどの工夫が有効です。

2.入力内容がChatGPTに学習されない設定にする

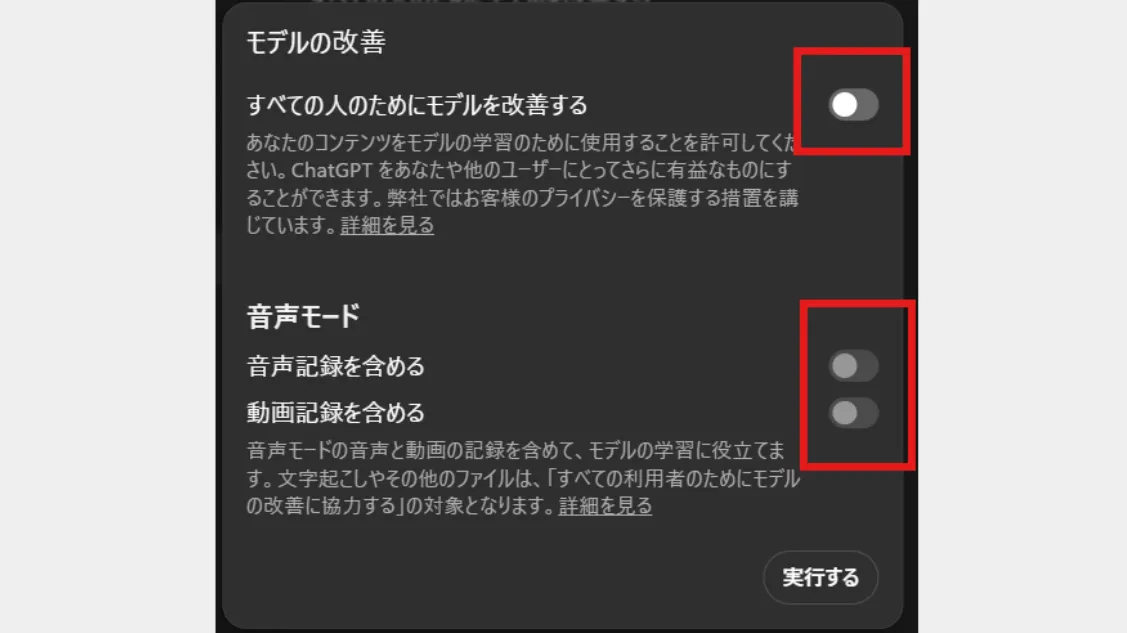

ChatGPTの設定で、入力内容が学習データに使用されることを防げます。この設定により、企業の機密情報が、意図せず他のユーザーの回答に含まれるリスクを大幅に軽減できます。

学習されない設定の手順

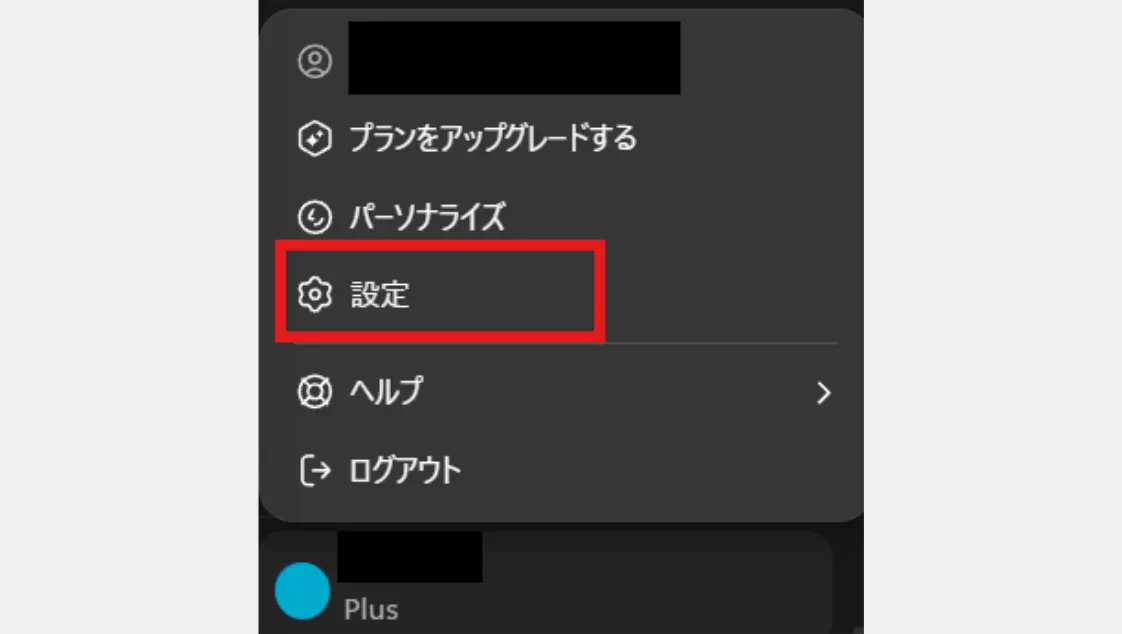

1.ChatGPTにログイン後、自分のアカウント名を選択

2.「Settings」or「設定」をクリック

3.「Data controls」or「データコントロール」から「Improve the model for everyone」or「すべての人のためにモデルを改善する」をクリック

4.スイッチをオフに切り替え

企業利用だけでなく、個人利用の方でも、こちらの設定にしておくことがおすすめです。

3.APIを利用する

ChatGPT API(Application Programming Interface)を利用することで、入力データが学習に使用されることを原則防ぐことができます。

API利用では、企業独自のアプリケーションとChatGPTを連携させることができ、より安全な環境での利用が可能です。

APIの主な利点

- 入力データが一切学習に使用されない

- 企業のシステムとの連携が可能

- より柔軟なカスタマイズが実現

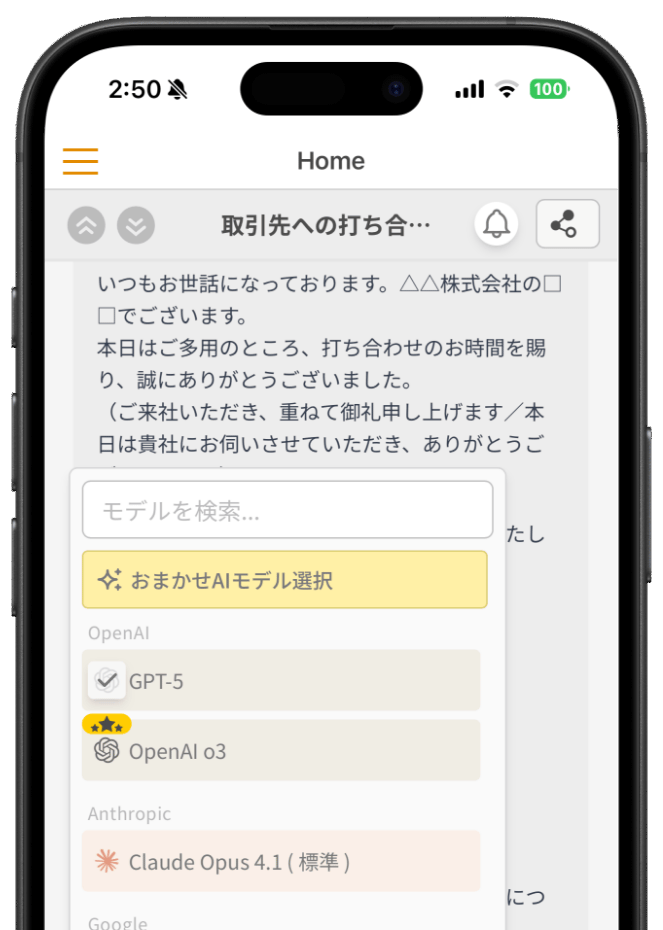

- 利用状況の詳細な把握が可能法人向け生成AIチャットサービス「ナレフルチャット」では、学習データに利用されないAPIを活用しており、企業がセキュアな環境で生成AIを利用できる仕組みを提供しています。

クローズドな環境で利用ユーザーは管理者が制限可能。ISMS認証(ISO27001)とプライバシーマークを取得しているCLINKS株式会社が運営・開発している点も安心材料です。

詳しくは、以下をご参照ください。

4.有料プランを利用する

ChatGPTの有料プランのうち、法人用プランである Business・Enterprise では、入力データがモデルの学習に利用されないことを明言されており、機密情報の漏洩リスクを大幅に低減できます。

上記プラン(Business・Enterprise)では、データ保持ポリシーの柔軟な設定や、詳細な監査ログ機能など、企業規模やセキュリティ要件に応じた管理機能が備わっています。

有料プラン(Business以上)の主なセキュリティ機能

- 入力データをモデル学習に利用しない保証

- SSO(シングルサインオン)対応

- ユーザー・権限管理機能

- 監査ログの提供 (Businessではやや限定的)ただし、Enterprise プランは個別見積もりが必要で、利用者数によっては料金が高額になる場合がある点には注意が必要です。中小企業が導入を検討する際は、まず Business プラン から始めて効果を検証し、その後必要に応じて Enterprise への移行を検討するのが現実的といえるでしょう。

5.定期的にパスワードを変更する

アカウントのセキュリティを維持するため、パスワードは定期的に変更しましょう。ChatGPTのアカウント情報が流出した場合でも、定期的にパスワードを変更することで、不正アクセスのリスクを軽減できます。

安全なパスワード管理のポイント

- 3ヶ月に1回程度で定期的に変更する

- 英数字と記号を組み合わせた12文字以上

- 他のサービスとの使い回しは厳禁

- 二段階認証(2FA)の有効化

- パスワード管理ツールの活用特に企業での利用においては、パスワードポリシーを策定し、従業員全体でセキュリティ意識を共有することが重要です。定期的にセキュリティ研修を実施することも効果的です。

6.社内での利用ルールを設ける

企業内でChatGPTを安全に活用するため、明確な利用ルールを策定し、それを従業員に周知することも必要です。利用ガイドラインを作ることで、組織全体で情報漏洩のリスクを軽減することができます。

利用ルールに含めるべき項目

- 許可する利用用途

- 入力禁止情報の具体例

- 生成した文書の管理・利用方法

- 違反時の処罰規定

- 相談窓口の設置上記に沿ってルールを策定した後はルールの遵守状況を定期的にチェックし、必要に応じて内容を見直すことも大切です。また、サムスン社の事例など、間違った使い方をした際の影響の周知も行いましょう。

7.入力情報の監視をする

企業のIT部門では、CASB(Cloud Access Security Broker)や SIEM(Security information and Event management) などのセキュリティ製品を導入することによって、従業員の ChatGPT 利用状況を可視化できるようになります。

これにより、「誰が」「いつ」「どこから」ChatGPT にアクセスしたかを把握し、利用の制御や監査を補助する運用が可能になります。

監視で把握可能な情報例

- 誰が ChatGPT にアクセスしたか

- アクセス日時・頻度

- 利用したデバイス・IP アドレス

- 利用時間やアクセスパターン

- 通常と異なる利用動作(異常検知)たとえば、CASB製品を使えば ChatGPT を含むクラウドサービスのアクセスをダッシュボードで管理することができます。ただし、監視を導入する場合は従業員への説明と合意形成、プライバシー保護、運用ポリシーの明確化が必須です。

8.セキュリティシステムを導入する

CASBとSIEMに加え、DLP(Data Loss Prevention)システムを導入することで、機密情報が ChatGPT に入力されるのを阻止・抑制できます。DLP は入力データの内容を分析し、個人情報やソースコード、契約書などのパターンを検出すると、自動的にブロックまたは警告を出すことが可能です。

DLPによって防げる可能性のある情報漏洩例

- 氏名、住所、電話番号などの個人情報

- クレジットカード番号、銀行口座情報

- 社内文書/契約書の文章

- 技術仕様書、ソースコードなど知的財産

- 機密情報に類するパターンデータDLP製品では、企業固有の機密パターン(顧客番号フォーマット、商品コードなど)を登録しておくこともできます。導入や運用には一定のコストが必要ですが、人的ミスによる情報漏洩リスクを大きく軽減することが可能です。

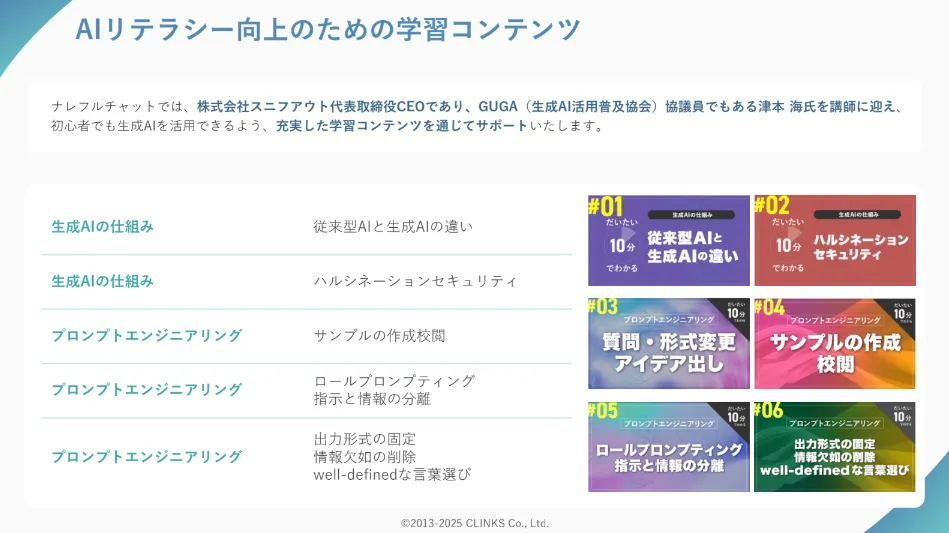

9.利用者のAIリテラシーを向上させる

従業員のAIリテラシー向上は、技術的な対策と同じくらい重要です。AIの仕組み、適切な利用方法、セキュリティリスクなどについて、定期的な教育を実施することで、従業員が自ら適切な判断を行えるようになります。

教育プログラムの実践例

- 書籍・動画でのインプット

- 外部セミナーへの参加

- プロンプト作成・AI活用についての社内研修

- 社内ルールの詳細説明

- 実践ワークショップAIやそれを取り巻く環境の変化は非常に速いため、継続的な教育を行い、組織全体で学び続ける文化を構築することが重要です。

ナレフルチャットでは、AIリテラシー向上支援のためのコンテンツを豊富に提供しています。

初心者でも分かりやすい動画での生成AI入門オリジナルコンテンツを用意しており、企業の従業員教育を効果的にサポートしています。

10.アカウントの使い回しをしない

企業でChatGPTアカウントを使いまわすことは、重大なセキュリティリスクを生み出します。共有アカウントでは、パスワード管理が甘くなりがちで、不正アクセスのリスクが高まるだけでなく、責任の所在も不明確になります。

アカウント共有の主なリスク

- 不正アクセスのリスク増大

- 元従業員によるアクセス

- 操作履歴の追跡が困難

- 責任の所在が不明確

- インシデント時の調査・対応が困難そのため、従業員一人ひとりに個別のアカウントを付与し、適切な管理を行うことが重要です。

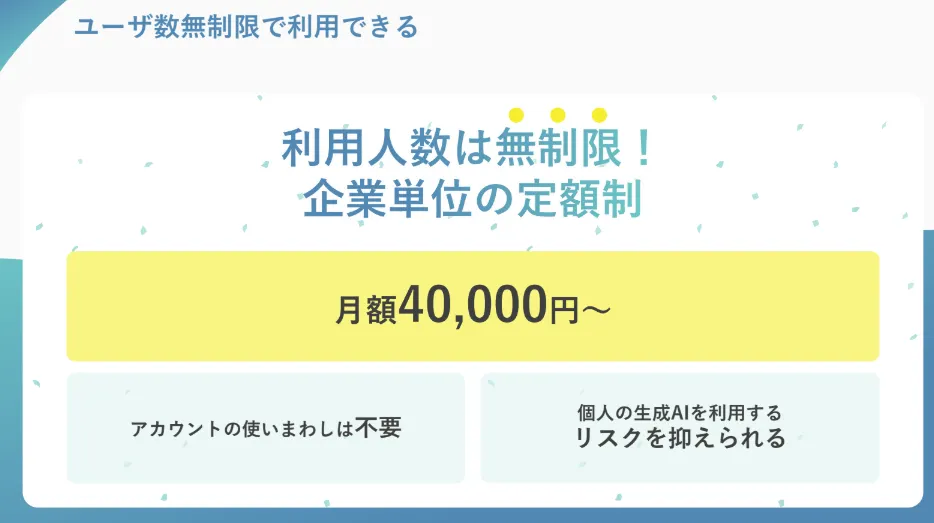

ナレフルチャットでは、アカウント課金ではなく企業単位での月額4万円からの定額制です。

利用人数も無制限のため、費用節約のためにアカウントを使いまわす必要はありません。そのため、安心して全社で導入できるのが特徴です。

11.法人向け生成AIサービスを導入する

ChatGPTではなく、企業向けに設計された生成AIサービスを導入することで、包括的なセキュリティ対策を実施することができます。

法人向けサービスでは、ChatGPTの有料プラン同様、データの暗号化、アクセス制御、監査ログ、管理機能などの企業に必要な機能に加え、カスタマーサポートや独自の機能などが備わっていることが多いです。

法人向けサービスの選定ポイント

- セキュリティ認証の取得状況(ISO27001など)

- データの取り扱い方針

- カスタマーサポート体制

- 料金体系

- 既存システムとの連携

- 自社の状況・業種業界・業務との適合導入時には、技術面だけでなく社内浸透のサポートが充実しているサービスを選ぶことが重要です。単にツールを導入するだけでは望んだとおりの効果は得られません。従業員が実際に活用できるような支援体制が整っているサービスを選択することで、より効果的な活用が期待できます。

ナレフルチャットなら情報漏洩リスクを抑えて生成AIを活用できる

これまで解説してきた通り、ChatGPTには入力データの学習利用、アカウント情報の流出、システム障害による履歴の漏洩など、企業にとって深刻な情報漏洩リスクが存在します。しかし、適切な対策を講じれば、生成AIを安全に業務活用することは十分可能です。

ナレフルチャットは、企業の情報漏洩リスクを最小化しながら、生成AIの恩恵を最大化できる法人向け生成AIチャットサービスです。

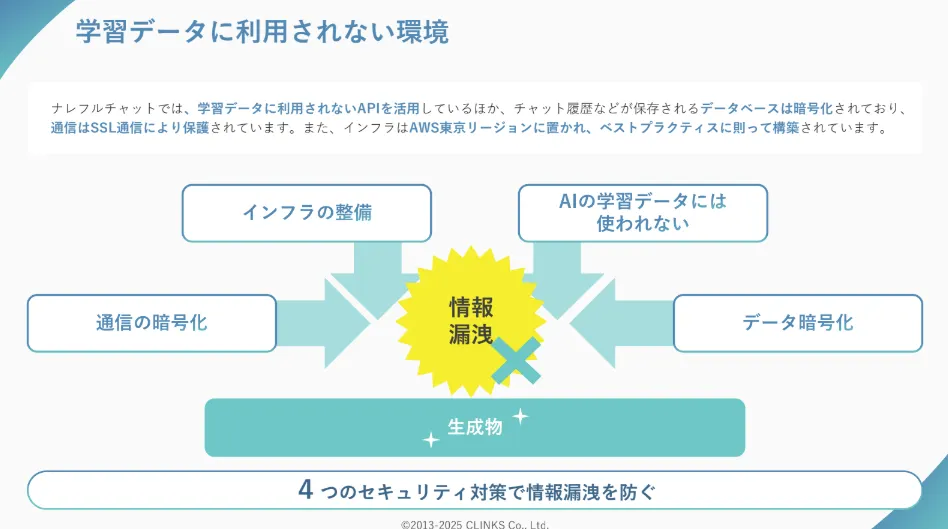

学習データに利用されないAPIを活用しているため、機密情報を入力しても学習データに一切使用されません。クローズドな環境で管理者がユーザーを制限でき、社内での情報共有も安全に行えます。

セキュリティ面では、ISMS認証(ISO27001)とプライバシーマークを取得した企業が開発・運営しており、企業レベルの情報保護基準をクリアしています。通信の暗号化やデータベースの暗号化など、包括的なセキュリティ対策を実装しています。

ナレフルチャットの情報漏洩対策

- 学習データに利用されないAPI活用

- ISMS認証・プライバシーマーク取得企業による運営

- 通信・データベースの暗号化

- 管理者によるユーザー制限機能

- ユーザーの利用状況(アクセスログ・利用ログ)を確認できる機能

- 社内限定のクローズド環境また、企業単位で月額4万円からの定額制のため、全従業員が個別アカウントを持つことが可能。そのため、アカウント共有による情報漏洩リスクも回避できます。

AIリテラシー向上支援として、プロンプト自動生成機能やテンプレート集、動画コンテンツも充実しており、セキュリティ意識を保ちながら効果的な生成AI活用を実現できます。

情報漏洩リスクを適切に管理しながら生成AIを導入したい企業は、ナレフルチャットをご検討ください。

ナレフルチャット運営チーム

法人向けクローズド生成AIチャットサービス「ナレフルチャット」の企画・開発・運用を手がけています。

プロンプト自動生成・改善機能や組織内でのノウハウ共有機能など、独自技術の開発により企業の生成AI活用を支援しています。

「AIって難しそう...」という心の壁を、「AIって面白そう!」という驚きで乗り越えていただけるように

日々刻々と変化する生成AI業界の最新動向を追い続け、魅力的な記事をお届けしていきます。