PLUS

生成AIコラム

ChatGPTのセキュリティリスクとは?安全に利用する対策方法を解説

目次:

はじめに

「ChatGPTを業務で使いたいけど、セキュリティは大丈夫?」「機密情報を入力しても問題ない?」「どんなリスクがあるの?」こうした疑問を持つ企業担当者は多いでしょう。

ChatGPTは業務効率化に役立つツールですが、情報漏洩や著作権侵害など、企業にとって深刻なセキュリティリスクも存在します。また、無料版と有料版ではセキュリティレベルに大きな違いがあるため、企業利用では適切なプラン選択が重要です。

本記事では、ChatGPTの主要なセキュリティリスクから具体的な対策方法まで、企業が知っておくべき情報を分かりやすく解説します。正しい知識を身につけて、ChatGPTを安全かつ効果的に活用していきましょう。

生成AIの導入をお考えの企業様へ

ナレフルチャットは企業の生成AI活用を安全かつ効率的に支援するツールです。セキュリティ対策から社内浸透まで、AI導入をトータルサポートいたします。企業でのAI活用を検討している方は、こちらをご覧ください。ChatGPTの学習の仕組み

ChatGPTのセキュリティリスクを理解するには、まず学習の仕組みを知ることが重要です。

ChatGPTは書籍、記事、ウェブページなど、インターネット上に公開されている膨大なテキストデータを学習しています。この学習プロセスにより、文章の構造やパターンを理解し、人間らしい自然な文章を生成できるようになります。

重要なのは、ユーザーが入力した情報が将来のAI学習データとして永続的にChatGPT内に蓄積される可能性があることです。つまり、企業の機密情報を入力すると、その情報が永続的にシステム内に保持され、他のユーザーの回答生成に影響を与える可能性があります。

この学習の仕組みが、次に説明するセキュリティリスクの原因となっています。適切な対策なしにChatGPTを利用すると、意図せずして重要な情報を第三者に公開してしまう危険性があるのです。

ChatGPTの仕組みについては以下の記事で詳しく解説していますので、ご参照ください。

参考記事:うさぎでもわかる ChatGPTの仕組み AIの中身をやさしく解説!

ChatGPTのセキュリティリスク

ChatGPTには企業活用において注意すべきセキュリティリスクが存在します。これらのリスクは企業の信頼性や経済活動に深刻な影響を与える可能性があるため、事前に理解をし、対策をすることが必要です。

ここでは、代表的な5つのセキュリティリスクについて解説します。

- 機密情報の漏洩

- 著作権・商標権などの権利侵害

- ハルシネーションによる誤情報の拡散

- 倫理的に不適切な表現の生成

- サイバー攻撃への悪用

機密情報の漏洩

一つ目が、上述した機密情報の漏洩です。ChatGPTに入力された情報は、将来のAIモデルの学習データとして使用される可能性があります。

そのため、個人情報では氏名、生年月日、住所、電話番号など、企業情報では顧客リスト、事業計画、財務データ、営業戦略などの機密情報はChatGPTに入力してはいけません。

これらの情報を不用意にChatGPTに入力すると、第三者が質問した際の回答生成に情報を使用されてしまう恐れがあります。

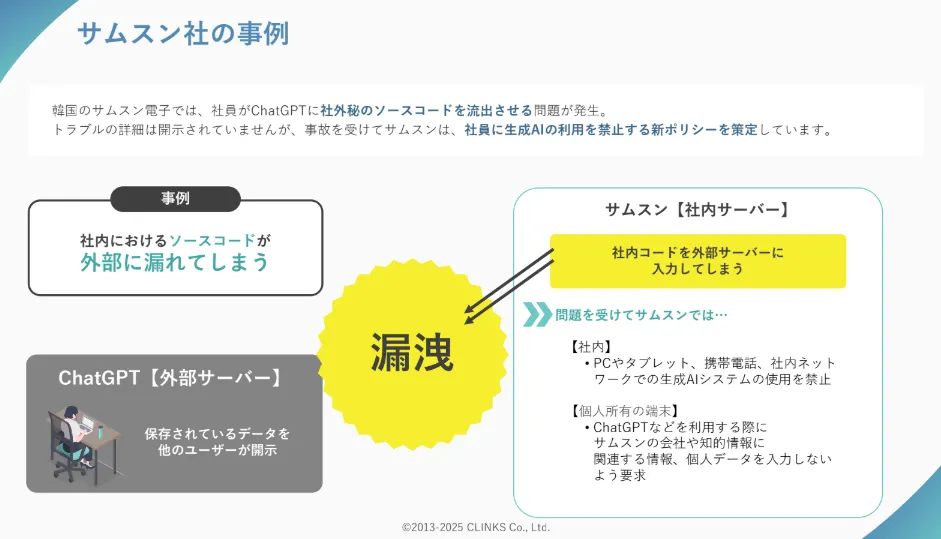

実際に、韓国のサムスン電子では、社員がChatGPTに社外秘のソースコードを入力してしまう問題が発生しました。

これによって起きたトラブルの詳細は開示されていませんが、この問題を受けてサムスンは、社員に対してChatGPTの利用を禁止する新ポリシーを策定する事態に発展しました。

著作権・商標権などの権利侵害

ChatGPTは学習データに含まれる著作物を参考にして回答を生成するため、著作権や商標権を侵害するリスクがあります。出力内容が既存の著作物と類似してしまう場合があるのです。

文章だけでなく、画像や動画の生成でも同様のリスクが存在します。企業がChatGPTで作成したコンテンツを商用利用する際は、特に注意が必要です。

著作権侵害が認定された場合、損害賠償請求や利用停止命令を受ける可能性があります。場合によっては刑事罰の対象となることもあり、企業の社会的信用に大きな影響を与えかねません。

なお、日本では著作権法第30条の4により、生成AIなどによる生成コンテンツは、思想又は感情の享受を目的としない場合には当該著作物の著作権が制限され、その目的範囲での利用が認められる場合があります。ですが、リスクがあることには変わりがないため、企業利用では慎重な判断が求められます。

参照:「著作権法(昭和四十五年法律第四十八号)」デジタル庁 e-GOV 法令検索

ハルシネーションによる誤情報の拡散

ハルシネーションとは、ChatGPTが存在しない情報や間違った内容を、事実であるかのように自信を持って回答してしまう現象です。生成された回答は論理的で説得力があることが多いため、真偽の判断が困難な場合が多いのが特徴です。

ハルシネーションは学習データの不足や偏り、古い情報に基づいた生成などによって発生します。特に最新の情報や専門的な分野では、不正確な情報が生成されやすい傾向があります。

また、ChatGPTは「正しい答えを返す」仕組みではなく、言葉の予測に基づいて文章を作る仕組みのため、自然な流れであれば誤った情報も生成してしまうのも大きな要因です。

注意すべきハルシネーションの典型例

- 実在しない企業や人物に関する詳細な説明

- 存在しない学術論文や書籍の引用

- 架空の統計データや調査結果の提示

- 誤った法律や制度に関する説明企業がハルシネーションを含む情報を顧客や取引先に提供すると、社会的信用の失墜や経済的損失を招く危険があります。また、間違った情報に基づいた意思決定により、事業活動に支障をきたす可能性も考えられます。

倫理的に不適切な表現の生成

ChatGPTは学習データに含まれるバイアスや不適切な表現を反映した回答を生成する場合があります。差別的な内容や偏見を助長する表現が含まれると、企業のブランドイメージに深刻な影響を与えかねません。

問題となる表現の種類は多岐にわたります。性別、年齢、国籍、宗教、職業などに関する固定観念に基づいた表現や、特定のグループを不当に評価する内容などが代表例です。これは、学習データ自体に含まれていた社会的なバイアスが反映された結果といえます。

倫理的に不適切な表現の具体例

- 「女性は論理的思考が苦手」など性別による能力の決めつけ

- 「高齢者はITに疎い」といった年齢による一般化

- 特定の国籍や地域の人々に対するステレオタイプ

- 職業による社会的地位の序列化表現

- 外見や身体的特徴に基づく差別的表現実際に、Amazonで導入されていた人材採用システムで、女性を差別するという機械学習面の欠陥が判明し、運用を取りやめる結果になった事例がありました。

参照:「焦点:アマゾンがAI採用打ち切り、「女性差別」の欠陥露呈で」Reuters

資料や顧客対応、SNSでの発信などでChatGPTを使用する際は、生成された内容の倫理的な適切さを慎重に検討する必要があります。

サイバー攻撃への悪用

ChatGPTは悪意のある目的で使用される可能性もあります。最も一般的なのが、不正な質問を通じて本来制限されている情報を引き出そうとする攻撃手法です。巧妙な言い回しで、有害なコンテンツを生成させたり、普段は回答しないような機密情報を回答させたりする試みが行われることがあります。

また、ChatGPTを使って大量のフィッシングメールやスパムメッセージを効率的に作成し、サイバー攻撃に利用される危険もあります。このような事件は今後増えていくことが予想されます。

新たな脅威として注目される攻撃手法

- AIを活用したソーシャルエンジニアリング攻撃

- 大規模な偽情報キャンペーンの自動生成

- 標的型攻撃メールの大量作成

- 音声合成技術と組み合わせたなりすまし詐欺さらに深刻な問題として、ChatGPT自体やChatGPTと連携するサービスがサイバー犯罪者に攻撃された場合、ChatGPTが学習した自社データが漏洩する危険性もあります。

ChatGPTは悪質なプロンプトには応答しないよう設計されていますが、その制限を回避する手法も日々進化しているため、企業としては常に最新の情報を把握し、適切な対策を講じることが重要です。このような事件は今後さらに増えていくことが予想されるため、予防策が求められます。

ChatGPT上で実施されているセキュリティ対策

ChatGPTの開発元であるOpenAI社は、上述の様々なリスクに対応するため、様々なセキュリティ対策を実装しています。企業利用においては、これらの対策内容を理解することが重要です。

- OpenAI社の取り組み

- ChatGPTのプランごとのセキュリティ対策

OpenAI社の取り組み

ChatGPTを運営するOpenAI社では、ユーザーの安全性を確保するために、包括的なセキュリティ対策を実施しています。技術的な保護措置からアクセス管理まで、多面的なアプローチでサービスの安全性向上に取り組んでいます。

主要なセキュリティ対策として、保存データの暗号化(AES-256)、通信時の暗号化(TLS1.2以上)、社内アクセス権限の厳格な制限などが実装されています。

また、ChatGPTは様々なセキュリティ認証を取得しています。

取得しているセキュリティ認証

しかし、運営会社レベルでセキュリティ対策が講じられていても、ユーザー側の使い方や設定によっては意図せずセキュリティリスクを高めてしまう可能性があるため、適切な利用方法の理解が重要です。

ChatGPTのプランごとのセキュリティ対策

ChatGPTではプランによって提供されるセキュリティ・プライバシー機能に差があります。個人向けプランでは基本的な暗号化や履歴管理機能はあるものの、企業利用で安心できるレベルではありません。一方、企業向けプランでは、データがモデル訓練に利用されない保証や、組織レベルでの高度な管理機能が備わっています。

プランごとのセキュリティ対策比較

| プラン | データの学習利用 | 認証・コンプライアンス |

|---|---|---|

| 無料版・Plus・Pro | 設定でモデル訓練への利用を防止することが可能 | 転送時TLS1.2+、保存時AES-256による暗号化 |

| Enterprise・Business | デフォルトでビジネスデータはモデル訓練に使われない保証あり | SOC 2監査済、AES-256・TLS1.2+による暗号化 |

参照:ChatGPT HP

企業で機密情報を扱う場合は、ビジネスデータがモデル訓練に使用されない明確な保証があるEnterprise・Businessプランの選択をおすすめします。このプランでは、組織全体でのアクセス制御や監査ログなどの企業向け管理機能も充実しており、安全な生成AI活用が可能です。

ChatGPT Enterpriseについて詳しく知りたい場合は、以下の記事をご参照ください。

参考記事:ChatGPT Enterpriseとは?他プランとの違い・導入時の注意点を解説

ChatGPT利用時のセキュリティ対策

企業がChatGPTを安全に活用するには、利用時に適切な対策をすることが必要です。

ここでは、代表的な3つの対策を紹介します。

- 学習データに利用されない環境を用意する

- 利用者のAIリテラシーを向上させる

- アカウントの使い回しをしない

学習データに利用されない環境を用意する

入力データが学習に利用されない環境の用意が最も重要な対策です。一般的な無料版ChatGPTでは、会話内容が将来の学習データとして使用される可能性があるため、企業利用には適していません。

API経由でChatGPTを利用すれば、データの学習利用を制限できるオプションを使用することが可能です。

OpenAI APIでは、適切な設定により入力データの学習利用を防ぐことができます。

ChatGPT BussinessやChatGPT Enterpriseでは、会話履歴の学習利用を制限できる設定が用意されています。特にEnterpriseプランでは、企業の要求に応じたカスタマイズが可能です。

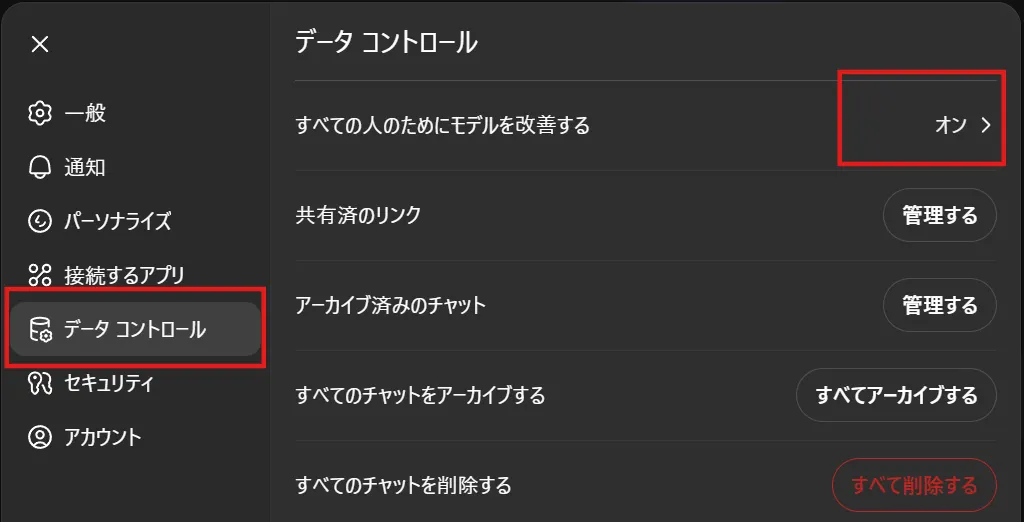

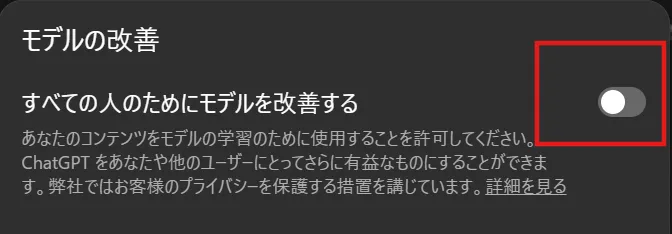

また、「すべての人のためにモデルを改善する」機能をオフにすることも重要です。これにより、ChatGPTの設定で過去の会話内容がサーバーに保存されることを防ぎ、情報漏洩のリスクを軽減できます。

まず、ChatGPTを開き、自分のアイコンをタップし「Setting」か「設定」を開きます。

そして、「データコントロール」から「すべての人のためにモデルを改善する」をクリックorタップしましょう。

そして、「すべての人のためにモデルを改善する」のチェックを外せば完了です。画像の状態が完了している状態です。

定期的にこの設定を確認し、適切な状態を維持することが大切です。

利用者のAIリテラシーを向上させる

ChatGPTを安全に活用するには、利用者のAIリテラシー向上も欠かせません。AIは急速に進歩している分野のため、継続的な学習と実践が重要です。

まず、AIが得意なタスクと苦手なタスクの把握が重要です。文章作成や情報整理は得意ですが、最新情報の提供や数値計算には限界があります。また、ハルシネーションの存在を知り、生成された回答を鵜呑みにしないことも必要です。特に、重要な意思決定や公開する情報については、必ず事実確認を行う習慣をつけるようにしましょう。

そのためには、定期的な研修や勉強会の開催により、組織全体のAIリテラシー向上を図ることが必要です。動画コンテンツや座学、外部の専門家を招いた講習で最新の動向や事例を学習するようにしましょう。

AIの進歩は非常に速いため、一度の研修で終わりではなく、継続的にアップデートされる情報をキャッチアップし、組織全体で学び続ける文化を構築することが安全で効果的なAI活用につながります。

アカウントの使い回しをしない

アカウントの使いまわし・共有は深刻なセキュリティリスクに繋がります。複数の従業員が同一アカウントを使用すると、誰がどのような情報を入力したか追跡できなくなるため、問題発生時の対応が困難になります。

セキュリティ面では、共有アカウントのパスワードが複数の人に知られることで不正アクセスのリスクが高まります。組織を離れた元従業員がアクセス権を保持し続ける可能性もあり、情報漏洩の原因となりかねません。

対策として、全従業員に個別のアカウントを付与することが重要です。部署ごとに管理者を設置し、アクセス権限を適切に管理する体制の構築もするようにしましょう。また、定期的なパスワード変更や二要素認証の導入により、セキュリティレベルを向上させることができます。

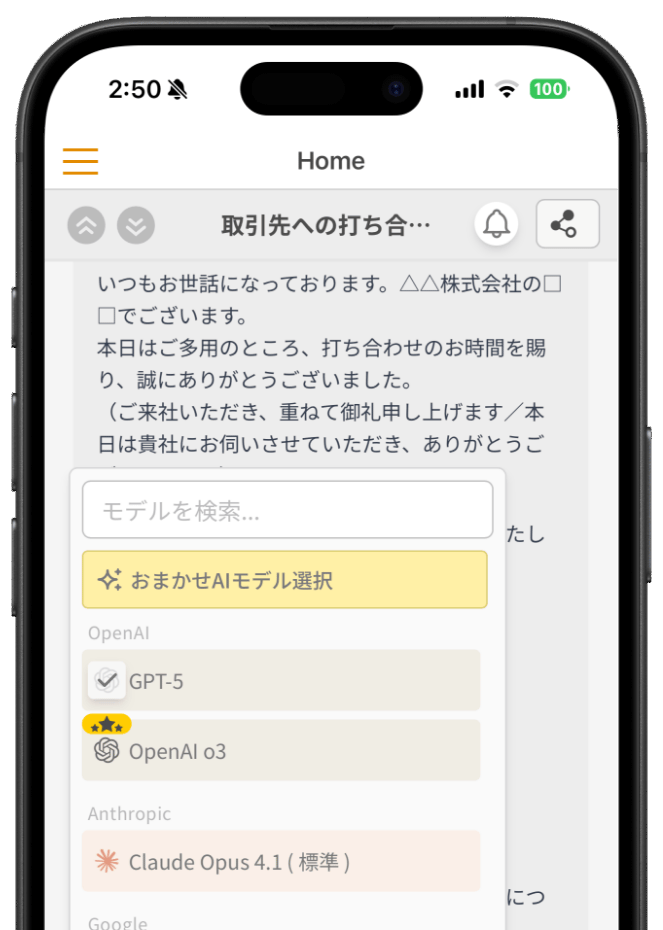

ナレフルチャットならリスク対策しつつ生成AIを活用できる

企業が生成AIを安全に活用するには、専門的な知識と適切なセキュリティ対策が不可欠です。ナレフルチャットは、これらの課題を解決し、企業が安心して生成AIを利用できる環境を提供しています。

ナレフルチャットでは、学習データに利用されない”API”を活用しているため、入力内容は学習データに一切利用されません。クローズドな環境で利用ユーザーは管理者が制限可能です。

また、ISMS認証(ISO27001)とプライバシーマークを取得した企業が開発・運営しており、企業レベルのセキュリティ基準を満たしています。

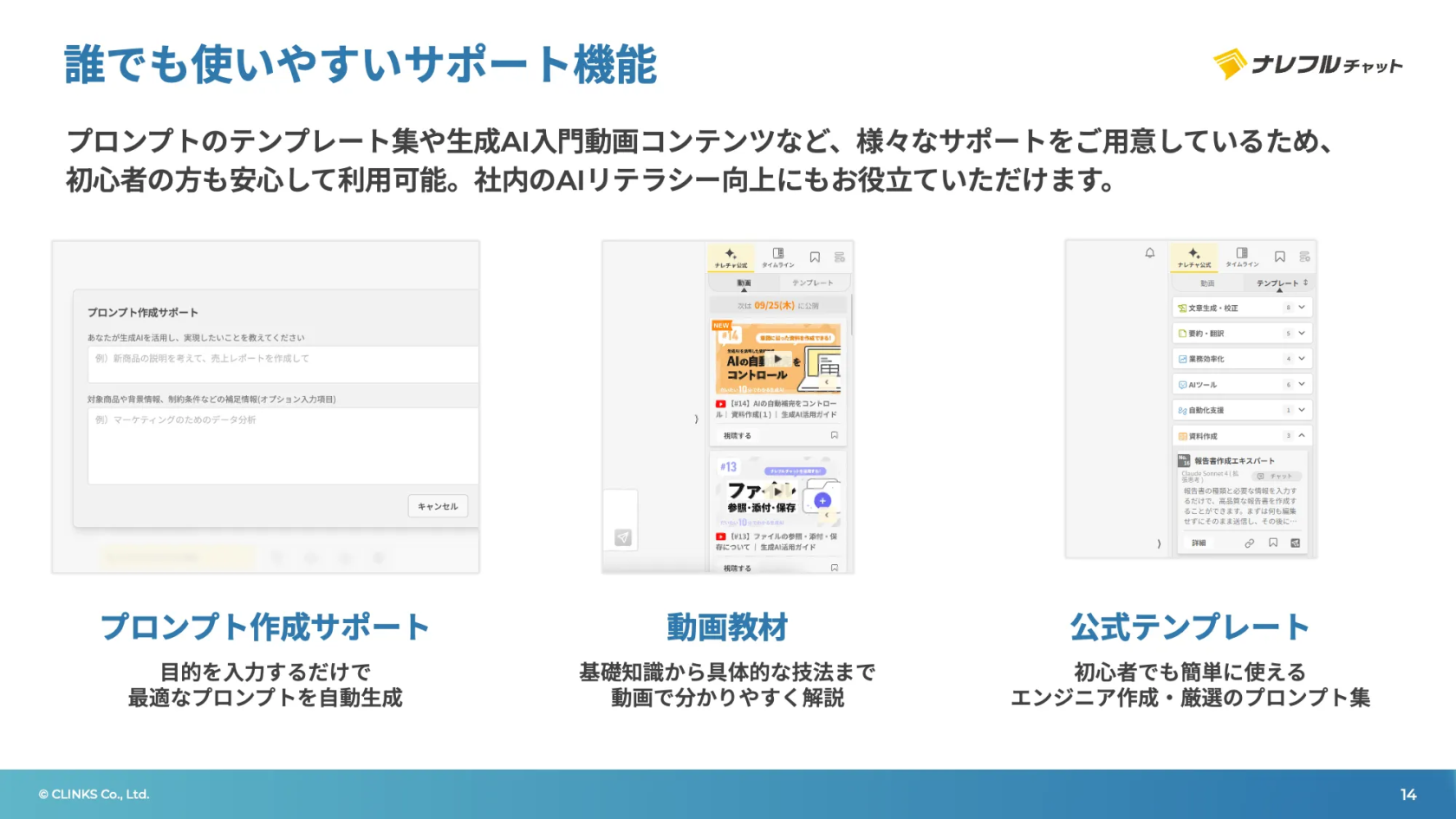

AIリテラシー向上支援も充実しており、プロンプト作成サポート機能やテンプレート集、初心者でも分かりやすいように動画でわかる生成AI入門オリジナルコンテンツをご用意しています。

さらに、企業単位の定額制のため、全社で生成AI導入が可能。利用人数に制限がないためアカウント使い回しのリスクを回避できます。

ユーザー数無制限でご利用いただけるナレフルチャットは、セキュリティへの配慮と組織全体での生成AI活用を同時に実現し、企業のDX推進をサポートします。

生成AIのリスクを適切に管理しながら活用したい企業は、ナレフルチャットの導入をご検討ください。

ナレフルチャット運営チーム

法人向けクローズド生成AIチャットサービス「ナレフルチャット」の企画・開発・運用を手がけています。

プロンプト自動生成・改善機能や組織内でのノウハウ共有機能など、独自技術の開発により企業の生成AI活用を支援しています。

「AIって難しそう...」という心の壁を、「AIって面白そう!」という驚きで乗り越えていただけるように

日々刻々と変化する生成AI業界の最新動向を追い続け、魅力的な記事をお届けしていきます。