PLUS

生成AIコラム

うさぎでもわかる!AIが起こすハルシネーションの原因と対策

はじめに

2025年現在、AI技術の急速な発展に伴い、ChatGPTやClaude、Geminiなどの大規模言語モデル(LLM)が私たちの日常業務に深く浸透しています。これらのAIツールは驚異的な性能を発揮する一方で、「ハルシネーション」という深刻な問題を抱えているうさ。

ハルシネーションとは、AIが実際には存在しない情報や、事実と異なる内容をあたかも真実のように自信満々で出力してしまう現象のこと。単なる技術的な不具合ではなく、ビジネスや社会全体に大きな影響を与える可能性があるため、適切な対策が不可欠なのうさ🐰

最新の調査によると、最新モデルでも完全にハルシネーションを排除することは困難な状況ですが、適切な対策技術を組み合わせることで、多くのユースケースにおいて実用的なレベルまでリスクを低減できるようになってきました。

この記事では、ハルシネーションの基本概念から最新の対策技術、そして今すぐ実践できる具体的な防止策まで、技術者の皆さんが安全にAIを活用するために必要な知識を分かりやすくお伝えするうさよ~

ハルシネーションとは何か~基本概念の理解~

ハルシネーション(AI幻覚)の定義

ハルシネーションは、生成AIが実際には存在しない情報や、事実と異なる内容を生成してしまう現象です。人間の幻覚になぞらえてこう呼ばれているうさが、AIの場合は「自信満々に間違った情報を提供する」という点が特に危険なのうさ。

従来のシステムなら「データが見つかりません」と正直に答えるところを、AIは「それらしい答え」を作り出してしまうため、利用者が間違いに気づきにくいという特徴があります。

うさぎの経験では、この「自信満々に間違える」というのが最も厄介な部分だと感じているうさ。人間なら「たぶん…」「確か…」のような曖昧な表現で不確実性を示すうさが、AIは断定的に答えがちなので、つい信じてしまうのうさよ🐰

具体的な例とその危険性

実際にどのようなハルシネーションが発生するのか、具体例を見てみるうさ。

金融分野での間違ったアドバイス

- 例 「○○銀行の住宅ローン金利は1.2%です」と存在しない金利情報を提供

- 影響 誤った情報に基づく投資判断で資産損失のリスク

- 対策の重要性 金融商品の選択には正確な情報が不可欠

法務文書での虚偽情報生成

- 例 存在しない判例や法律条文を引用して契約書を作成

- 影響 コンプライアンス違反や訴訟リスクの増大

- 対策の重要性 法的文書は一文字の間違いも許されない

技術文書での存在しないAPIの説明

- 例 実在しないライブラリのメソッドや、廃止されたAPIの使用方法を説明

- 影響 開発プロジェクトの遅延やシステム障害

- 対策の重要性 技術情報の正確性は開発効率に直結

これらの問題は「AIを盲信する」文化が組織に根付いたときに特に深刻化すると感じているうさ🐰

最初は「AIなら間違わないだろう」と思っていましたが、実はAIほど堂々と間違える存在はないと気づいたうさよ~。でも、その特性を理解して適切に使えば、とても頼もしいパートナーになるのうさ!

ハルシネーション発生の根本原因~なぜ起こるのか~

ハルシネーションはなぜ発生するのでしょうか。その原因を理解することが、効果的な対策の第一歩なのうさ。

技術的原因

確率的な言語生成メカニズム

LLMは次に来る単語を確率的に予測して文章を生成しています。学習データに存在しない情報について質問されると、「それらしい」単語の組み合わせを確率的に選択してしまうため、事実と異なる内容が生成されてしまうのうさ。

これは人間が「なんとなくそれっぽい答え」を言ってしまうのと似ているうさが、AIの場合はその「なんとなく」が非常に巧妙で説得力があるため、見抜くのが困難になっているのうさ。

うさぎの実感では、AIは「文章を作るプロ」だから、たとえ内容が間違っていても「読みやすくて説得力のある文章」に仕上げてしまうのが怖いところなのうさよ~🐰

訓練データの偏りと不完全性

AIモデルは大量のテキストデータから学習しますが、その中には間違った情報や偏った見解も含まれています。また、学習データには限界があるため、すべての分野について完璧な知識を持っているわけではありません。

モデルの過信問題

現在のLLMは、自分が知らないことを「知らない」と認識することが苦手です。不確実な情報についても、確信を持って答えてしまう傾向があるため、利用者が間違いに気づきにくくなっているうさ。

コンテキスト長の制限

LLMには一度に処理できる文字数に制限があります。長い文脈の中で矛盾が生じたり、重要な情報が欠落したりすることで、不正確な回答が生成されることがあります。

データ関連原因

学習データのカットオフ時期

多くのLLMには「学習データのカットオフ時期」があります。例えば、2024年1月までのデータで学習されたモデルは、それ以降の最新情報について正確に答えることができません。

うさぎがよく遭遇するのは「2025年の最新トレンド」について質問したとき、AIが古い情報を基に答えてしまうケースなのうさ。これは仕方ないことなのうさが、利用者が意識していないと間違った情報をもらってしまうのうさよ~

学習データのカットオフについては、以下の記事でも解説しているので良ければご参照ください。

参考記事:ChatGPTの学習データはいつまで?最新データを取得する3つの方法も解説

矛盾する情報の学習

インターネット上には矛盾する情報が多数存在します。LLMはこれらの情報を区別することなく学習するため、状況に応じて異なる「正解」を提示してしまうことがあります。

不足した知識での補完

あまり一般的でない専門分野の質問に対して、LLMは限られた学習データから「推測」で答えを生成しようとします。この推測が間違っていることが多々あるのうさ。

使用環境による要因

曖昧なプロンプト

「最近のAI技術について教えて」のような曖昧な質問は、AIが推測で答えざるを得ない状況を作り出します。具体性に欠けるプロンプトほど、ハルシネーションが発生しやすくなります。

存在しない情報への誘導

「○○会社の2025年の新製品について教えて」のように、存在しない情報を前提とした質問は、AIに虚偽の情報を生成させる原因となります。

過度に複雑な要求

一度に多くの条件を含む複雑な質問は、AIが処理しきれずに部分的に間違った情報を生成する原因となることがあります。

これらの原因を理解しておくことで、ハルシネーションが起こりやすい場面を予測し、適切な対策を講じることができるようになるうさよ~🐰

2025年最新のハルシネーション対策技術

2025年現在、AI研究コミュニティと産業界では様々な対策技術が開発されています。ここでは特に効果的とされている最新技術を紹介するうさ。

RAG(Retrieval-Augmented Generation)の進化

RAGの基本仕組み

RAGとは、検索拡張生成と呼ばれる技術で、AIが回答を生成する前に外部のデータベースや文書から関連情報を検索し、その情報を基に回答を生成する仕組みです。

従来のLLMが「記憶」だけに頼って回答していたのに対し、RAGは「参考書を調べてから答える」ようなアプローチを取ることで、より正確な情報を提供できるようになったのうさ。

うさぎの感覚では、RAGは「カンニングペーパー付きの試験」みたいなもので、正解が書いてある資料を見ながら答えられるから、間違いが減るという感じなのうさよ~🐰

RAGについては、以下の記事でも解説しているので良ければご参照ください。

参考記事:RAGとは?ChatGPTで社内データを活用する方法・注意点を解説

2025年版RAGの特徴

最新のRAG技術には以下のような進化が見られます。

マルチホップ検索

複数回の検索を繰り返すことで、より網羅的な情報収集を実現する手法なのうさ

うさぎの解説🐰

まるで図書館で本を探すときに、最初に見つけた本の参考文献リストを見て、さらに別の本を探すような感じなのうさ!一度の検索では見つからない深い情報まで辿れるようになったのうさよ~具体例

「Python機械学習ライブラリの最新動向」について質問されたとき

- 最初の検索 「Python 機械学習」で基本情報を取得

- 二回目の検索 見つかったライブラリ名(scikit-learn、TensorFlow等)で詳細情報を検索

- 三回目の検索 各ライブラリの「2024年アップデート」で最新情報を検索

この方法により、表面的な情報だけでなく、具体的で最新の技術動向まで正確に把握できるのうさ!

知識グラフ統合

構造化された知識データベースと連携することで、より正確な情報の関連付けが可能になった技術なのうさ

うさぎの解説🐰

これは「情報の家系図」みたいなもので、「A社はB社の子会社で、C技術を開発している」といった関係性を正確に把握できるようになったのうさ!単純なキーワード検索では見落としがちな「つながり」を理解できるのが画期的なのうさよ~具体例

「Google AI部門の最新研究」について質問されたとき

- 従来 「Google」「AI」「研究」のキーワードで曖昧な検索

- 知識グラフ統合後

- Google → Alphabet Inc. → Google AI → DeepMind

- 関連人物 Jeff Dean、Demis Hassabis等

- 関連技術 Transformer、BERT、LaMDA等

- 最新プロジェクト Gemini、Bard等

このように構造化された知識により、正確で包括的な情報を提供できるのうさ!

リアルタイム更新

最新の情報を動的に取得し、学習データのカットオフ時期の問題を解決する仕組みなのうさ

うさぎの解説🐰

これは「常に最新の新聞を読んでから答える」ような仕組みなのうさ!AIの「知識の賞味期限切れ」問題を解決する革新的な技術なのうさよ~具体例

株価情報を質問されたとき

- 従来のRAG 静的なデータベースから古い株価情報を取得

- リアルタイム更新RAG

- 現在時刻を確認(2025年7月30日 14時30分)

- リアルタイム株価APIから最新データを取得

- 直近の市場動向ニュースも同時に検索

- 「14時30分現在の株価は○○円、直近のニュース影響により前日比+2%」

この方法で、学習データが古くても常に最新情報に基づいた回答ができるのうさ!

うさぎの実感では、この3つの技術が組み合わさることで、RAGの精度が格段に向上したと感じているうさ。特にリアルタイム更新は「AIが時代遅れになる」問題を解決してくれる素晴らしい技術なのうさよ~🐰

プロンプトエンジニアリングの高度化

Chain-of-Thought(思考の連鎖)手法

AIに「段階的に考えて答えて」と指示することで、推論過程を明示させる手法です。これにより、どこで間違った推論をしているかを特定しやすくなり、結果として正確性が向上します。

例

- 悪い質問 「東京オリンピックの開催年は?」

- 良い質問 「東京オリンピックの開催年について、段階的に考えて答えてください。まず、過去に東京で開催されたオリンピックを確認し、次に最新の開催年を特定してください。」

Few-shot学習による改善

質問と一緒に正しい回答例を複数提示することで、AIの回答精度を向上させる手法です。特に専門分野での質問において効果的とされています。

確実性要求プロンプト

「分からない場合はその旨を答えてください」「確信が持てない情報については推測であることを明記してください」といった指示を追加することで、AIの過信を防ぐことができます。

うさぎの経験では、このプロンプト改善だけでも相当な効果があると実感しているうさ。「わからないことは素直にわからないと言う」ことを教えてあげるだけで、AIがずっと信頼できるパートナーになるのうさよ~🐰

マルチエージェント・デベート技術

複数のAIエージェントが同じ質問に対してそれぞれ回答し、互いの答えを検証・議論させる技術です。一つのAIが間違った情報を生成しても、他のAIがそれを指摘することで、最終的により正確な答えにたどり着くことができます。

これらの技術は単独で使うよりも組み合わせて使うことで、より高い効果を得られると感じているうさ🐰

即実践できるハルシネーション対策

技術的な対策も重要ですが、今すぐ実践できる基本的な対策も同じくらい大切なのうさ。ここでは、誰でもすぐに始められる効果的な方法を紹介するうさよ~

プロンプト改善テクニック

プロンプトの書き方を工夫することで、ハルシネーションの発生を抑えることができます。

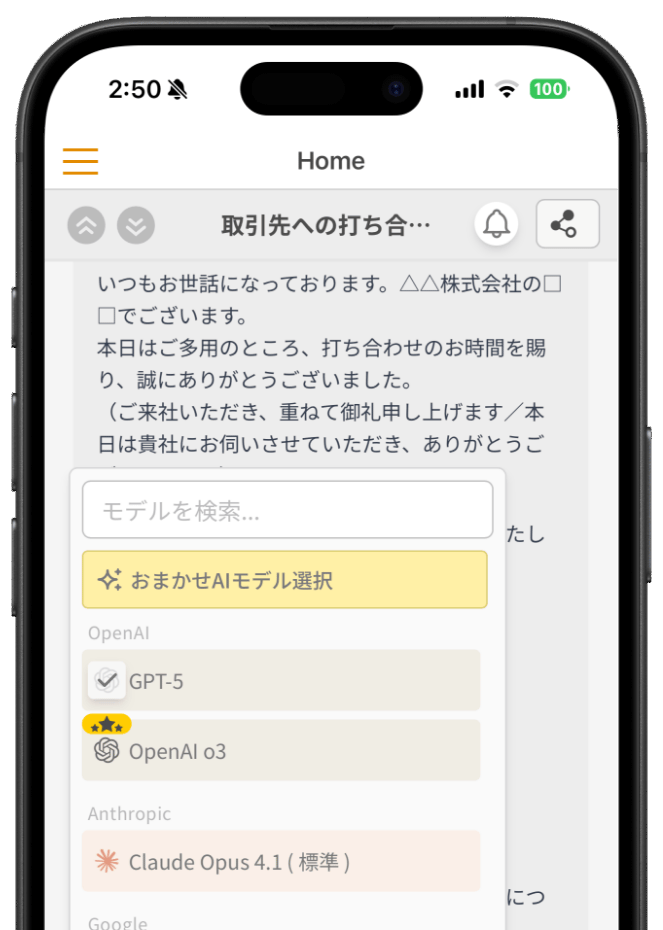

なお、ナレフルチャットでは、プロンプトを書き慣れていない人に向けて「プロンプト作成のサポート機能」を提供しています。

やりたいことを一行入力するだけで高精度なプロンプトが作成できるので、AI初心者でもハルシネーションに惑わされることなく、求めている回答をもらいやすくなります。

具体的で明確な指示の書き方

ハルシネーションを防ぐ最も基本的な方法は、AIに具体的で明確な指示を出すことです。

悪い例

最近のAI技術について教えて良い例

2024年に発表されたRAG(Retrieval-Augmented Generation)技術の

具体的な改善点を3つ挙げて、それぞれの技術的特徴を説明してください。

もし情報が不確実な場合は、その旨を明記してください。良い例では、以下の要素が含まれているうさ

- 時期の明確化(2024年)

- 技術名の具体化(RAG)

- 求める情報の詳細化(改善点を3つ)

- 不確実性への対処指示

うさぎの実感では、プロンプトを「具体的にする」だけで8割方の問題は解決すると感じているうさよ~。曖昧な質問をすると、AIも曖昧に答えざるを得ないのは当然なのうさ🐰

存在確認を促すプロンプト

情報の存在を前提とせず、まず存在するかどうかを確認させることで、虚偽情報の生成を防げます。

例

「○○株式会社の2025年新製品発表」について調べたいのですが、

まずこの情報が実際に存在するかどうかを確認してください。

存在する場合のみ、詳細を教えてください。思考過程の説明要求

AIに推論過程を説明させることで、どこで間違った判断をしているかを特定できます。

例

以下の質問について、段階的に考えて答えてください

1. まず、関連する背景情報を整理

2. 次に、確実に分かる事実を列挙

3. 最後に、推測部分があれば明確に分けて回答複数情報源によるクロスチェック

異なるAIツールでの検証

同じ質問を複数のAIツール(ChatGPT、Claude、Geminiなど)で試し、回答を比較することで、明らかな矛盾や誤りを発見できます。

うさぎがよく使う4ステップ検証法

- 複数AI確認 3つ以上のAIツールで同じ質問をする

- 回答比較 共通する内容と異なる内容を整理

- 一次情報確認 公式サイトや信頼できる文献で事実確認

- 専門家相談 重要な判断の場合は人間の専門家に相談

一次情報源での確認手順

AI生成の情報については、必ず信頼できる一次情報源で確認する習慣をつけることが大切です。

確認すべき一次情報源の例

- 企業の公式サイト

- 政府機関の公式発表

- 学術論文やプレプリント

- 業界団体の公式資料

ファクトチェック習慣の構築

チェックすべき要素

特に注意深く確認すべき要素は以下の通りうさ

数字・統計データ

- 金額、割合、年号は必ず検証

- 「約」「およそ」が付いていても油断しない

固有名詞

- 人名、企業名、製品名はひとつひとつ確認

- 存在しない論文や書籍の引用に注意

最新情報

- 「2025年7月現在」といった表現には特に注意

- AIの学習データのカットオフ時期を意識

専門的な内容

- 医療、法律、金融などの専門分野は特に慎重に

- 人命や資産に関わる情報は必ず専門家に確認

うさぎの実感では、特に「数字」と「固有名詞」は要注意なのうさ。AIは数字を作るのがとても上手(?)だから、もっともらしい統計データを生成してしまうことがあるのうさよ~🐰

効果的なファクトチェックの流れ

- 即座チェック 明らかにおかしい情報はその場で指摘

- 情報源確認 「この情報の出典を教えてください」と追加質問

- 複数角度検証 異なる観点から同じ事実を確認

- 時系列確認 情報の日付や更新時期を意識

これらの対策は少し手間がかかるうさが、安全にAIを活用するためには欠かせないプロセスなのうさ。最初はこう考えていましたが、実はこの手間こそが「AIリテラシー」の重要な部分だと気づいたうさよ~🐰

まとめ

ハルシネーション対策について、基本概念から最新技術、実践的な対策まで幅広く解説してきましたうさ。ここまで来れば大丈夫です!

完全防止は困難、でも大幅削減は可能

2025年現在の技術では、ハルシネーションを完全に排除することは困難です。しかし、適切な対策技術と運用方法を組み合わせることで、実用的なレベルまでリスクを大幅に削減することは可能になっています。

うさぎの感覚では、「完璧を求めず、実用的なレベルを目指す」というのが2025年現在のリアルな目標設定だと思っているうさよ~🐰

適切な用途での活用が重要

AIの活用においては、「どこで使うか」が非常に重要です。

低リスク分野での積極活用

- アイデア出しや文章の構成案作成

- ルーティン作業の効率化

- クリエイティブな活動の支援

高リスク分野での慎重な活用

- 医療、法律、金融分野では補助ツールとして使用

- 必ず人間の専門家による最終確認を実施

- 複数の検証プロセスを経た上で判断

継続的な学習と改善の必要性

ハルシネーション対策は一度設定すれば終わりではありません。AI技術の進歩に合わせて、対策手法も継続的にアップデートしていく必要があるうさ。

- 最新の対策技術についての情報収集

- 社内でのインシデント共有と改善

- 定期的な精度評価と検証プロセスの見直し

最後に

お疲れ様でした!AIは確かに革新的なツールですが、その限界を理解し、適切な対策を講じることで、安全かつ効果的に活用できるようになります。

「ハルシネーションを制する者がAIを制する」時代において、皆さんがより安心してAIを活用できるよう、この記事が少しでもお役に立てれば嬉しいうさ🐰

最初はハルシネーション問題を難しく考えていましたが、実は「AIの性格を理解して、適切に付き合う」ことが一番大切だと気づいたうさよ~。AIも完璧ではないからこそ、私たち人間がしっかりとサポートしてあげることで、素晴らしいパートナーシップが築けるのうさ!

みなさんも日々のAI活用で気をつけているポイントがあれば、ぜひ共有してくださいうさよ~!

あなたも生成AIの活用、始めてみませんか?

生成AIを使った業務効率化を、今すぐ始めるなら

「初月基本料0円」「ユーザ数無制限」のナレフルチャット!

生成AIの利用方法を学べる「公式動画」や、「プロンプトの自動生成機能」を使えば

知識ゼロの状態からでも、スムーズに生成AIの活用を始められます。

taku_sid

https://x.com/taku_sid

AIエージェントマネジメント事務所「r488it」を創立し、うさぎエージェントをはじめとする新世代のタレントマネジメント事業を展開。AI技術とクリエイティブ表現の新たな可能性を探求しながら、次世代のエンターテインメント産業の構築に取り組んでいます。

ブログでは一つのテーマから多角的な視点を展開し、読者に新しい発見と気づきを提供するアプローチで、テックブログやコンテンツ制作に取り組んでいます。「知りたい」という人間の本能的な衝動を大切にし、技術の進歩を身近で親しみやすいものとして伝えることをミッションとしています。